Copilot, assistente do Github, enfrenta uma acusação de pirataria

“O que é meu, é meu; o que é seu, é meu também”. Esse foi aparentemente o princípio que guiou a Microsoft, o GitHub e a OpenAI durante o deselvolvimento do Copilot, um assistente de programação baseado em Inteligência Artificial. Pelo menos, é isso que um processo judicial contra as três empresas dá a entender.

Lançado em Junho de 2021, o Copilot é apresentado pelo GitHub como uma “Inteligência Artificial programadora” capaz de “sugerir códigos e funções inteiras em tempo real”. Quando alimentado por um prompt de linguagem natural, o Copilot responde com blocos de código. Ele consegue fazer isso graças a seu outro produto de IA, o Codex, desenvolvido pela OpenAI e integrada no Copilot, disponível para programadores do GitHub em troca de uma assinatura de US$10 por mês, ou de US$100 por ano.

A OpenAI treinou o Copilot utilizando códigos de repositórios públicos do GitHub. Por mais que a Microsoft afirme que a ferramenta foi treinada a partir de “bilhões de linhas de código”, ela não menciona explicitamente como obteve acesso a este verdadeiro tesouro. De acordo com o processo, liderado pelo programador e advogado Matthew Butterick, é aí que está o problema.

O argumento é que a ferramenta viola as licenças de código aberto dos usuários do GitHub, as quais a Microsoft prometeu respeitar após comprar a plataforma, em 2018. Mais especificamente, o processo acusa o Copilot de não exibir informações de copyright ou indicar que os seus resultados são derivativos, afirmando, portanto, que são “alcançados através da pirataria de software em uma escala sem precedentes”. O processo alega ainda que o Copilot “com frequência simplesmente reproduz códigos que podem ser encontrados em repositórios ou licenças de código aberto.”

A OpenAI argumenta que o Codex não deveria estar sujeito às condições das licenças por configurar “uso justo transformativo.” A empresa afirma que códigos abertos foram usados como dado de treinamento “com propósito de pesquisa” e nunca foi pensado para ser um “verbatim” incluído nos resultados. A empresa ainda afirma que mais de 99% dos resultados do Codex “não é correspondente aos dados de treinamento.”

Mas os reclamantes alegam que isso é exatamente o que está acontecendo.

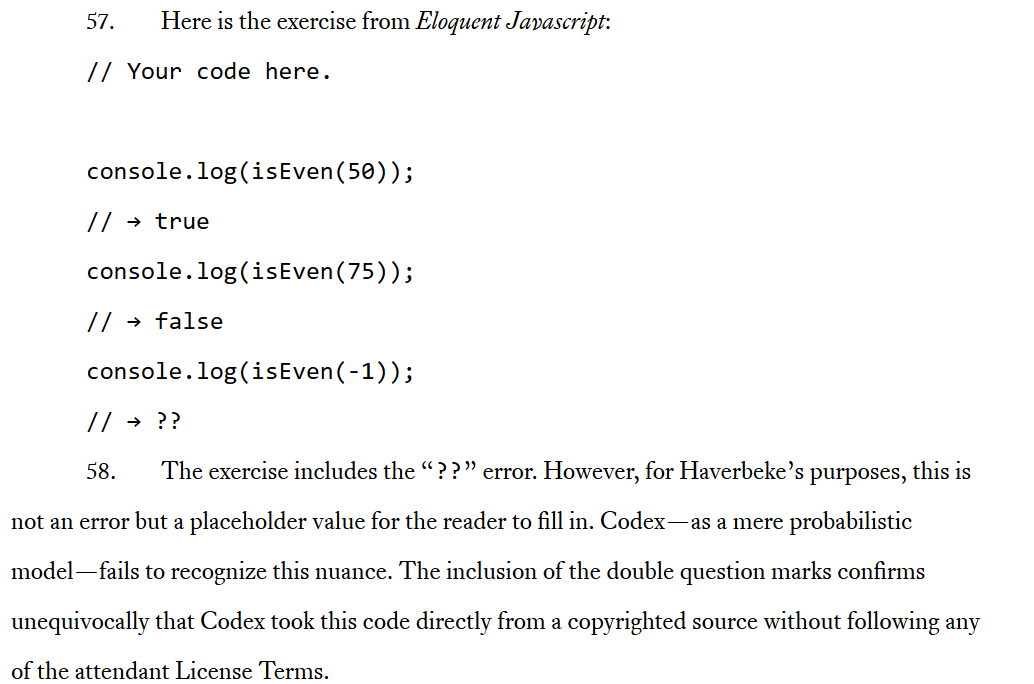

Por exemplo, a reclamação menciona o livro Javascript eloquente, de Marijn Haverbeke, que possui a licença não-comercial da Creative Commons. O códido no livro também é licenciado pelo MIT. De acordo com os termos desta licença, o Copilot precisaria ter incluído os direitos autorais em uma nota e solicitado permissão. Isso porque o Copilot, em seu design, não foi treinado para respeitar qualquer tipo de termos e condições de uso, afirma o processo. Isso explica em detalhe como o Codex copia fontes com copyright de maneira direta e efetiva, incluindo o livro de Haverbeke.

Print: Excerto do processo detalhando como o Codex supostamente copia “diretamente de fontes com copyright.”

Não é apenas Butterick que vem apontando para a premissa questionável sobre a qual o Copilot foi construído. No mês passado, o desenvolvedor e professor de Ciência da Computação no A&M Texas, Tim Davis, chegou basicamente à mesma conclusão. Davis tuitou que o Copilot copiou “grandes quantidades” de seus códigos com copyright sem dar crédito nenhum. Além disso, o assistente baseado em IA pareceu reconhecer que estava copiando o código de Davis. O pesquisador afirmou que, quando ele pediu que o Copilot produzisse um código “no estilo de Tim Davis,” ele recebeu um versão “ligeiramente alterada” de seu código. O inventor do Copilot, Alex Graveley, minimizou a importância das similaridades, afirmando que o código era “parecido, mas diferente.”

Por mais que exista um eterno debate sobre as fronteiras entre plágio e inspiração, o processo afirma que o Copilot está mais próximo do primeiro. Apesar das afirmações da empresa, “na prática… o resultado é frequentemente uma reprodução quase idêntica do código dos dados de treinamento,” afirma o processo.

Os reclamantes também contestaram o argumento da OpenAI de que usar código aberto para construir um software comercial constitui “uso justo” e beneficia a comunidade. Este uso “não é justo, permitido ou justificável,” diz o processo, acusando o Copilot de “reunir uma grande quantidade de código aberto disponível para todos e colocá-los dentro de um paywall controlado pelo GitHub.”

Em um outro post em seu blog, Butterick descreve o Copilot como “nada mais do que uma interface alternativa conveniente para acessar um grande coleção de códigos de acesso livre.” E, sendo assim, os assinantes do Copilot podem violar as regras das licenças de código aberto de desenvolvedores licenciados involuntariamente. Mas, de acordo com Butterick, o problema é ainda mais profundo. Ao servir como um intermediário entre autores de códigos livres e programadores iniciantes, a Microsoft remove “qualquer incentivo” para que os usuários do Copilot descubram comunidades de código aberto. A longo prazo, ele pode lidar com um rombo devastador que acabaria com a comunidade e roubaria o seu engajamento, que iria diretamente para “a carteira do Copilot,” defende Butterick. Ao chamar o Copilot de “parasita” que suga os contribuidores open source, ele acusa a Microsoft de “trair tudo o que o GitHub sempre defendeu.”

Não houve pedido de consentimento

Pode ser tentador culpar apenas a Microsoft da controvérsia com o Copilot. O gigante da tecnologia está diretamente ligado com a OpenAI, tendo investido US$1 bilhão na empresa e buscando investir ainda mais. Poderia-se dizer que todos os gigantes da tecnologia têm o hábito de roubar dados de usuários por lucro (não é preciso ir muito além do Meta e do Google), mas o fato de que não há regras ou padrões a serem seguidos para os sistemas de treinamento de AI deixa esta situação toda ainda mais complexa.

Legalmente, não há nada que impeça que empresas como a OpenAI e a Stability AI (mais conhecida pelo seu gerador de imagens a partir de textos, o Stable Diffusion) treinem seus modelos de Inteligência Artificial a partir de informações pessoais, conteúdo com direitos autorais, imagens médicas… basicamente qualquer conteúdo disponível online. As bases de dados em que estes modelos de IA generativa são treinados são compostas por enormes quantidades de dados sem filtros retirados de toda a internet. Fica a critério das empresas por trás dos produtos de Inteligência Artificial refiná-las ao remover qualquer conteúdo ofensivo ou sexualmente explícito da base de treinamento. No entanto, existe pouco incentivo para que estas empresas façam algo além disso. Ferramentas como a Have I Been Trained ajudam os usuários a pesquisar seus dados entre materiais de treinamento de IA disponíveis ao público para que possam solicitar a sua remoção, mas trata-se de apenas um grãozinho de areia na praia da proteção de dados e privacidade. Antes de tudo, não é nada fácil encontrar algo específico ali e, além disso, ninguém garante que o conteúdo seja de fato excluído. Além disso, se você encontrar seus dados no banco de dados, isso quer dizer que ele provavelmente já foi usado para treinar a IA e pode já ser parte de algum produto baseado neste tipo de tecnologia.

Assim, na prática, você pode somente impedir que os seus dados sejam usados para treinar uma inteligência artificial somente após o seu uso. O caso de Copilot parece ter sido a primeira vez em que alguém de fato tenha questionado o modelo de aprendizagem de uma inteligência artificial através de um processo judicial e, por isso, trata-se de um marco importante, mesmo que as críticas já tenham aparecido há muito tempo. No começo desse ano, um sindicato de artistas do Reino Unido lançou uma campanha para “impedir que as IA roubem toda a atenção para si.” Uma de suas principais demandas é que o governo torne ilegal a reprodução de obras de artes por parte de uma AI sem o consentimento do artista.

Pode-se concluir, portanto, que a falta de um mecanismo para não dar permissão a este uso indiscriminado e a questão do consentimento vêm ocupando uma posição de destaque nos debates sobre Inteligência Artificial.

Não se trata do que você faz, mas de como você faz

Como afirmou por Butterick, a principal objeção dos criadores, tanto dos programadores (como no caso do Copilot), quanto dos artistas visuais, não é a Inteligência Artificial de uma forma geral, mas sim a forma como as empresas criadoras destas ferramentas estão agindo.

“Nós podemos facilmente imaginar um versão do Copilot mais amigável com os criadores de códigos de acesso livre. Por exemplo, tornando a participação voluntária, ou então pagando programadores para contribuir para o corpus de treinamento,” escreve ele.

Algumas plataformas como a Getty Images estão banindo qualquer tipo de arte gerada por IA, outras estão buscando seguir os caminhos sugeridos por Butterick. Por exemplo, o Shutterstock, que recentemente começou a vender conteúdo gerado por IA como parte de sua parceria com o OpenAI e a LG, anunciou que adicionaria uma opção de recusa de permissão para as contas dos contribuidores. Esta função “permitirá aos artistas excluir seu conteúdo de qualquer base de dados do futuro se eles preferirem não contribuir para o treinamento de IA com o conteúdo que produzem.” Além disso, o Shutterstock criou um Fundo de Contribuidores, que poderia ser utilizado para compensar os artistas pelo uso de suas criações para o treinamento de modelos de IA. O DeviantArt também está dando aos criadores os meios necessários para bloquear sistemas de IA de roubar o seu conteúdo. Uma tag HTML especial será aplicada às páginas do DevianArt de artistas que pediram que o seu trabalho não seja usado par ao treinamento de IA. Terceiros terão que fitrar conteúdo com essa tag, de acordo com os termos de serviço do site. Vale notar que, tecnicamente, os sistemas de IA ainda assim conseguirão captar esses dados.

No entanto, estes exemplos ainda representam uma exceção à regra e, sem uma regulamentação, eles jamais serão maioria. O processo contra o Copilot, além de colocar os holofotes sobre os problemas envolvendo o treinamento de IA, pode também desencadear uma mudança importante. Por isso, mesmo que uma única reclamação não seja capaz de mudar todo o sistema, ela pode causar um efeito dominó, estimulando mudanças na legislação e uma eventual regulamentação. Considerando que novos produtos baseados em IA vêm surgindo em todo canto, é preciso regular as empresas por trás delas antes que seja tarde demais, antes que elas tenham se apropriado de todos os nossos dados.

Contribuindo ainda para o problema, está o fato de que os Gigantes da Tecnologia, notórios pela sua falta de consideração com a privacidade e proteção aos dados de usuário, estão liderando esta revolução das Inteligências Artificiais. Sabe-se que o Google está trabalhando em vários projetos de código de Inteligência Artificial, incluindo o Pitchfork. Esta ferramenta secreta, que ainda está sendo desenvolvida, irá supostamente corrigir seu próprio código escrito por Inteligência Artificial. O objetivo por trás deste projeto foi otimizar a os updates da base de códigos da linguagem de programação Python do Google. Mais especificamente, livrar-se de engenheiros de software e deixar que a IA faça todo o trabalho. De acordo com o Business Insider, que conversou com fontes internas do Google, os objetivos do projeto mudaram um pouco, e agora consistem em transformar a ferramenta em um “sistema de uso geral.”

Nova tecnologia, mesmo mau uso de dados

Resta saber quais serão os resultados da tentativa de desafiar o Copilot por parte dos programadores do GitHub e se isso terá algum efeito significativo na indústria como um todo. Por outro lado, o problema dos sistemas generativos de IA está em uma área cinzenta entre uso legítimo e infração de direitos de autor.

Por outro lado, este problema já existe há muito tempo. Em seu cerne, está o mau uso de dados de usuários por parte das grande corporações de tecnologia, que representam uma ameaça por si só. Nós podemos tentar resolver a parte especificamente ligada à IA desta controvérsia através de novas regras e leis, mas, conforme vimos nas tentativas da União Europeia e dos Estados Unidos de garantir a proteção de nossos dados das Big Tech, até mesmo leis mais duras não são um impedimento. As Big Tech sempre encontrarão brechas para contornar as regras de privacidade e leis de proteção de dados. Mas isso não significa que a nossa comunidade não tenha que pressionar os governos a desenvolver estas regras e regulamentações, e os gigantes da tecnologia a seguí-las.