«Второй пилот» GitHub попал в аварию: ИИ-помощника программиста обвиняют в пиратстве и ждут в суде

«Что твое, то моё, а что моё, то тоже моё» — видимо, этим принципом руководствовались Microsoft, GitHub и OpenAI при разработке Copilot, нейросетевого «помощника программиста» на базе технологий искусственного интеллекта. По крайней мере, это следует из коллективного иска пользователей GitHub, в котором они обвинили Copilot в нарушении авторских прав.

Выпущенный в июне 2021, Copilot — это «помощник программиста», который «предлагает код и целые функции в режиме реального времени». На практике это означает, что если на естественном языке описать задачу, то Copilot предложит готовые блоки кода для её решения. Алгоритм делает это при помощи другого продукта OpenAI — Codex. Пользователям GitHub «второй пилот» доступен по подписке: 10 долларов в месяц или 100 долларов в год.

Copilot учился писать код на примере открытого кода из публичных репозиториев GitHub. В рекламных материалах к Copilot Microsoft сообщает, что тот был обучен на «миллиардах строках кода», но не упоминает, где именно ассистент разработчика нашёл их. Согласно иску, автором которого является программист и юрист Мэтью Баттериком, в этом и заключается главная проблема.

Баттерик утверждает, что «второй пилот» нарушает условия лицензий с открытым исходным кодом пользователей GitHub, которые Microsoft обязалась соблюдать после покупки платформы в 2018 году. В частности, в иске говорится о том, что Copilot не отображает информацию об авторских правах и никак не указывает на то, что его результат является вторичным. Таким образом, Copilot «занимается пиратством программного обеспечения в беспрецедентных масштабах». Также в иске утверждается, что Copilot «часто просто воспроизводит код, который можно найти в репозиториях с открытым исходным кодом или связать с владельцами лицензий open source».

В свою очередь, OpenAI настаивает, что компания должна быть освобождена от лицензионных требований, так как Codex (а вместе с ним и Copilot) являются примером «преобразующего добросовестного использования» (transformative fair use). В компании заявляют, что открытый исходный код был использован в качестве обучающего материала «в исследовательских целях» и никогда не был предназначен для включения verbatum в конечный продукт. Помимо этого OpenAI утверждает, что более 99% выходных данных Codex «не совпадают с данными обучения».

Авторы иска с этим не согласны и приводят примеры, доказывающие обратное.

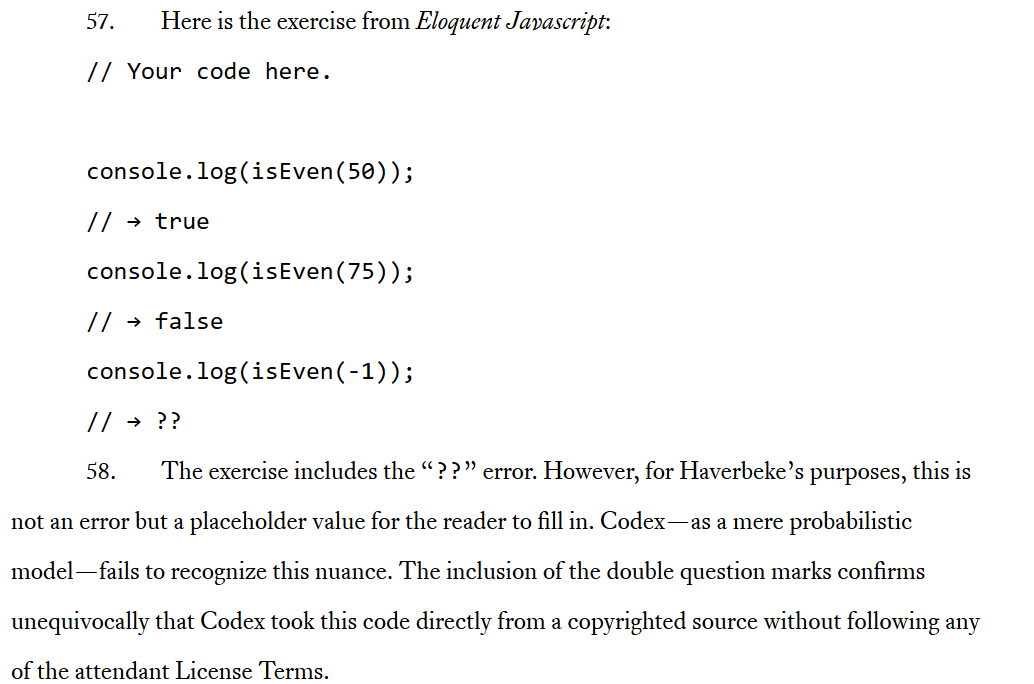

Так, в иске упоминается книга Eloquent Javascript («Выразительный Javascript») за авторством Marijn Haverbeke, распространяемая на основе лицензии Creative Commons Attribution-Noncommercial, согласно которой разрешается свободное использование произведения и в некоммерческих целях при условии указания автора. Код в книге также защищён разрешительной лицензией MIT. По условиям этой лицензии программисты могут использовать код в закрытом программном обеспечении при условии, что текст лицензии предоставляется вместе с этим ПО. Истцы утверждают, что Copilot не соблюдает условия этих лицензий. В тексте документа они приводят примеры того, как Codex копирует код непосредственно из источников, защищённых авторским правом, в том числе из книги Хавербеке.

Скриншот: выдержка из судебного иска с описанием того, как Codex якобы копирует код «непосредственно из источника»

Не только Баттерик обвиняет Copilot в фактическом воровстве кода. С ним согласен профессор компьютерных наук в Техасском университете A&M и разработчик Тим Дэвис, который поймал Copilot с поличным. По словам Дэвиса, Copilot воспроизвёл «большие куски» его кода без указания авторства. Более того, «второй пилот», похоже, был в курсе, чей код он копирует. Дэвис рассказал, что когда он попросил Copilot написать код «в стиле Тима Дэвиса», то он получил «слегка видоизменённую» версию своего кода. Создатель Copilot Алекс Грейвли не стал отрицать сходства между строками кода, но указал на то, что хотя код похожий, но не идентичен.

Споры о том, где проходит грань между плагиатом — то есть когда вы выдаёте чужой труд за своей собственной без ссылки на автора — и т.н. «вдохновением» не утихнут никогда. Согласно иску, история Copilot скорее представляет собой первый случай, чем второй. Несмотря на заверения компаний, «на практике… результат часто представляет собой почти идентичное воспроизведение кода из обучающих данных», говорят истцы.

Баттерик также не согласен, что использование открытого кода для создания коммерческого продукта, каковым является Copilot, может считаться «добросовестным». Подобное использование «не является ни добросовестным, ни разрешенным, ни оправданным», утверждается в иске. Согласно ему, компании, стоящие за Copilot, стремятся «заменить собой значительную часть сообщества open source, поместив её за пейволл».

В своём блоге юрист назвал Copilot«всего лишь удобным альтернативным интерфейсом» с помощью которого можно получить доступ «к большому корпусу открытого кода». Используя этот «интерфейс», подписчики Copilot могут, сами того не подозревая, нарушать open source лицензии своих коллег-разработчиков, отметил он. Выступая в качестве посредника между авторами открытого кода и начинающими программистами, Microsoft лишает пользователей Copilot «любого стимула» становиться активным участником опенсорс-сообщества, что в долгосрочной перспективе может нанести по нему сокрушительный удар, так как вся активность будет сосредоточена в «огороженном саду Copilot», пишет Баттерик. По мнению программиста, Copilot является «паразитом», который присваивает чужой труд, а Microsoft нарушает основополагающие принципы GitHub.

Согласие не требуется

Может возникнуть соблазн свалить всю вину за ситуацию с Copilot на одного недобросовестного игрока — Microsoft. Техногигант тесно связан с OpenAI: Microsoft уже инвестировал в компанию 1 миллиард долларов и не планирует на этом останавливаться. Нужно отметить, что это не первый раз, когда Big Tech безвозмездно использует что-то принадлежащее пользователям для собственного обогащения (в случае с Meta и Google этим чем-то являются наши личные данные). Однако, отсутствие правил и стандартов в области обучения систем искусственного интеллекта также способствует возникновению таких спорных ситуаций.

С юридической точки зрения ничто не мешает OpenAI и другим игрокам индустрии обучать свои модели ИИ на личных данных пользователей, на произведениях, защищённых авторским правом, и даже на медицинских изображениях… в общем, на всём, что можно найти онлайн. Компании, создающие ИИ-продукты, применяют различные фильтры, чтобы отсеять оскорбительные и непристойные изображения. Однако стимулов защищать авторское право или конфиденциальность пользователей у них нет. Эта обязанность лежит на самих пользователях. Например, на сайте Have I Been Trained можно поискать свои фотографии в базе учебных материалов для ИИ, чтобы затем потребовать их оттуда удалить. Но, во-первых, найти свои личные данные в базе непросто, а во-вторых, никто не гарантирует их удаление. Более того, если вы обнаружили своё фото в базе, это означает, что оно, скорее всего, уже было использовано для обучения ИИ и стало частью продукта.

Иск против Copilot стал первой попыткой оспорить подход к обучению ИИ в суде и поэтому является важной вехой, но подобная критика звучала давно. Так, в начале этого года профсоюз британских артистов создал кампанию под названием «Не дадим ИИ украсть шоу». Артисты требуют правительство признать незаконным воспроизведение искусственным интеллектом чужих работ без согласия автора.

Тема об отказе от участия в обучении ИИ постепенно выходит на первый план в спорах о его влиянии на нашу жизнь.

Дело не в том, что вы делаете, а в том, как вы это делаете

Как пишет Баттерик, авторы контента (в истории с Copilot — программисты) видят самую большую проблему не в технологии ИИ как таковой, а в том, как компании, создающие инструменты на основе ИИ, используют её.

«Мы можем легко представить себе более дружелюбную к разработчикам программного обеспечения с открытым исходным кодом версию Copilot — например, такую, где участие является добровольным, или где кодерам платят за вклад в корпус обучающих материалов», — пишет Баттерик.

Тогда как одни платформы, такие как Getty Images,запрещают размещать изображения, созданные ИИ, другие идут по пути, указанном Баттериком. Например, Shutterstock, который недавно начал продавать контент, созданный ИИ, в рамках партнерства с OpenAI и LG, предоставил автором изображений право отказа на участие в обучении ИИ. Кроме того, Shutterstock создал Фонд контрибьюторов, который будет выплачивать компенсацию авторам, чья интеллектуальная собственность была использована при разработке моделей ИИ. Схожим образом поступило и крупнейшее социальное онлайн-сообщество художников DeviantArt, которое предоставляет авторам возможность запрещать ИИ-инструментам использовать их контент. DevianArt будет применять специальный HTML-тег к страницам тех художников, которые не хотят, чтобы их работы использовались в обучении ИИ. Стоит отметить, что технически системы ИИ по-прежнему смогут собирать эти данные, но если они будут продолжать это делать, то нарушат правила сервиса.

Однако маловероятно, что подобное уважительное отношение к авторским материалам станет нормой без соответствующей законодательной базы. Иск к Copilot, помимо того, что он помогает пролить свет на проблему обучения ИИ, может стать толчком к необходимым изменениям. Если даже этого не произойдёт сразу, то он может спровоцировать череду аналогичных исков.

Проблема усугубляется тем, что революцию ИИ возглавляют крупные технологические компании, печально известные своим пренебрежением к конфиденциальности и защите пользовательских данных. Так, известно, что Google работает над рядом ИИ-инструментов для генерирования кода, в том числе над секретным проектом под названием Pitchfork. Pitchfork — это ИИ-инструмент, который, по задумке его создателей, должен будет уметь писать и редактировать собственный код. Цель проекта изначально была в том, чтобы создать инструмент, который мог бы сам обновлять кодовую базу языка программирования Python компании без участия человека. По данным издания Business Insider, которое поговорило с источниками в Google, с тех пор цели проекта изменились в сторону более универсальных.

Новые технологии, старые схемы

Время покажет, что выйдет из попытки пользователей GitHub бросить вызов Copilot и как это отразится (если отразится вообще) на индустрии ИИ в целом. С одной стороны, данная проблема возникла потому, что ИИ и его обучение — новая, стремительно развивающаяся область, которая находится в серой зоне между добросовестным использованием и нарушением авторских прав.

С другой стороны, проблема стара как мир. В её основе лежит злоупотребление данными пользователей со стороны технологических корпораций, которые считают их своей собственностью. Мы можем попытаться решить специфическую для ИИ часть этой проблемы при помощи новых законов. Однако как показали попытки отдельных стран и, в особенности, ЕС, защитить личные данные пользователей от посяганий Big Tech на государственном уровне, даже самые строгие законы не являются стопроцентной гарантией защиты конфиденциальности. Крупные технологические компании всегда будут искать лазейки, которые бы позволили им обойти законы о защите данных. Но это не значит, что мы не должны оказывать давление на регуляторов, чтобы они разработали эти законы, а также на технологических гигантов, чтобы они их соблюдали.