Copilot, l'assistant GitHub fait face à un problème

“Ce qui est à toi est à moi, et ce qui est à moi est à moi” - c'était apparemment le principe qui guidait Microsoft, GitHub et OpenAI lors du développement de Copilot, un assistant de codage alimenté par l'IA. C'est du moins ce que laisse entendre l'action en justice collective initiée contre le trio.

Lancé en juin 2021, Copilot est présenté par GitHub comme un "programmeur IA en binôme " capable de "suggérer du code et des fonctions entières en temps réel ". Lorsqu'il reçoit une demande en langage naturel, CoPilot répond avec des blocs de code. Il est capable de le faire grâce à un autre produit d'IA, Codex, développé par OpenAI et intégré à Copilot. Copilot est disponible pour les programmeurs de GitHub en échange d'un abonnement de 10 dollars par mois ou de 100 dollars par an.

OpenAI a entraîné Copilot sur du code provenant de dépôts GitHub accessibles au public. Si Microsoft affirme que Copilot a été formé sur "des milliards de lignes de code ", elle ne mentionne pas explicitement comment elle est tombée sur un tel trésor. Selon l'action en justice, menée par le programmeur et avocat Matthew Butterick, c'est là que réside le problème.

La plainte affirme que l'outil viole les licences open source des utilisateurs de GitHub que Microsoft s'est engagé à respecter après avoir acheté la plateforme en 2018. Plus précisément, la plainte accuse Copilot de ne pas afficher les informations relatives au droit d'auteur ou d'indiquer d'une manière ou d'une autre que sa production est dérivée, et affirme qu'il "accomplit ainsi le piratage de logiciels à une ampleur sans précédent ". L'action en justice allègue que Copilot "reproduit souvent simplement du code qui peut être retracé à partir de dépôts de sources ouvertes ou de détenteurs de licences de sources ouvertes ".

Pour sa part, OpenAI soutient que Codex devrait être exempté des exigences de licence parce qu'il répond à la définition de l'"utilisation équitable transformative". La société affirme que le code source ouvert a été utilisé comme données d'entraînement "à des fins de recherche " et n'a jamais été destiné à être inclus "verbatim " dans le résultat. Elle poursuit en affirmant que plus de 99 % des résultats de Codex "ne correspondent pas aux données de formation ".

Mais les plaignants affirment que c'est exactement ce qui se passe.

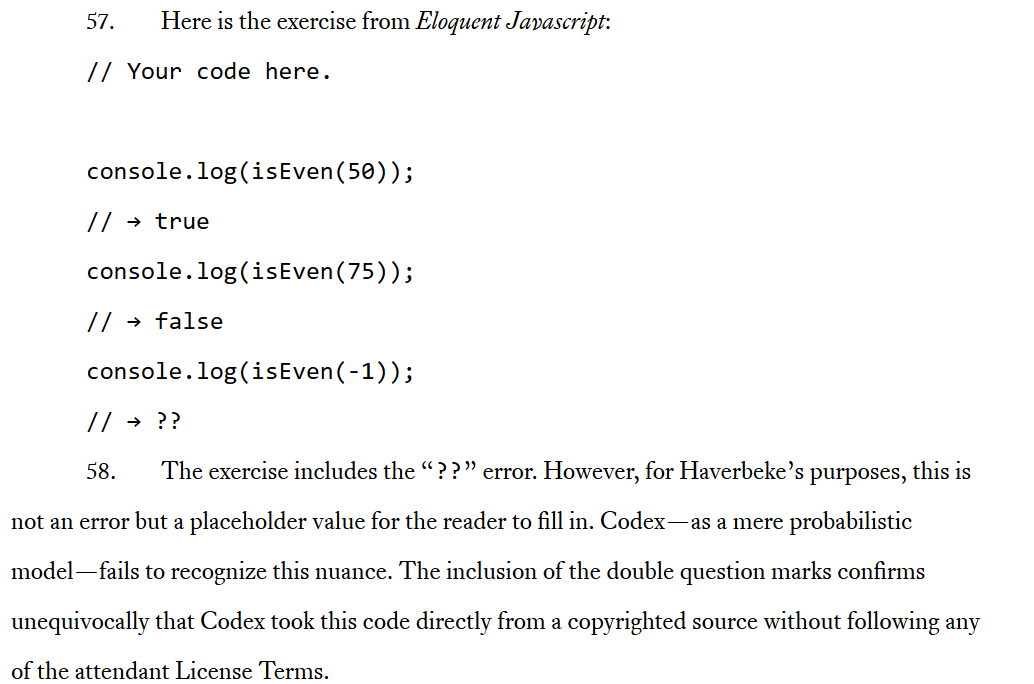

À titre d'exemple, la plainte mentionne le livre Eloquent Javascript de Marijn Haverbeke, qui est sous licence Creative Commons Attribution-Noncommercial. Le code du livre est également sous licence sous une licence MIT. Selon les termes de cette licence, Copilot est tenu d'inclure un avis de droit d'auteur et un avis d'autorisation, mais il ne le fait pas. Cela est dû au fait que Copilot n'a pas été formé pour respecter les termes de la licence par conception, indique l'action en justice. Elle explique ensuite en détail comment Codex copie effectivement le code directement à partir de sources protégées par le droit d'auteur, y compris à partir du livre de Haverbeke.

Prise d'écran: Extrait de l'action en justice détaillant comment Codex aurait copié du code "directement à partir d'une source protégée par le droit d'auteur".”

Butterick n'est pas le seul à pointer du doigt les prémisses douteuses sur lesquelles repose Copilot. Le mois dernier, Tim Davis, développeur et professeur d'informatique à Texas A&M, est arrivé à peu près à la même conclusion. M. Davis a tweeté que Copilot reprenait "de gros morceaux " de son code protégé par le droit d'auteur, sans attribution. En outre, l'assistant doté d'une intelligence artificielle semblait même reconnaître que c'était le code de Davis qu'il copiait. Le chercheur a déclaré que lorsqu'il a demandé à Copilot de produire un code "dans le style de Tim Davis ", il a obtenu une version "légèrement modifiée " de son code. L'inventeur de Copilot, Alex Graveley, a minimisé les similitudes, affirmant que le code était "similaire, mais différent ".

Bien qu'il y ait eu un éternel débat sur la ligne de démarcation entre le plagiat - qui consiste à présenter le travail de quelqu'un d'autre comme le sien sans même mentionner l'auteur original - et l'inspiration, l'action en justice affirme que Copilot s'apparente davantage au plagiat. Malgré les assurances données par les entreprises, "en pratique ... le résultat est souvent une reproduction quasi identique du code des données d'entraînement ", indique l'action en justice.

Les plaignants s'en prennent également à l'argument de l'OpenAI selon lequel l'utilisation du code à source ouverte pour construire un produit commercial constitue un "usage loyal " et profite à la communauté du code source ouvert. Une telle utilisation "n'est ni équitable, ni autorisée, ni justifiée ", indique l'action en justice, accusant Copilot de chercher à "remplacer une grande partie du code source ouvert en le prenant et en le gardant à l'intérieur d'un mur payant contrôlé par GitHub ".

Dans un billet de blog séparé, Butterick décrit Copilot comme "simplement une interface alternative pratique pour un large corpus de code open-source". Et si c'est le cas, alors les abonnés payants de Copilot peuvent involontairement violer les licences de code source ouvert de leurs collègues développeurs. Mais selon Butterick, le problème est plus profond. En servant d'intermédiaire entre les auteurs de logiciels libres et les programmeurs débutants, Microsoft supprime "toute incitation " pour les utilisateurs de Copilot à découvrir les communautés de logiciels libres. À long terme, cela peut porter un coup dévastateur à la communauté des logiciels libres dans son ensemble, en la privant d'un engagement qui se déplacerait plutôt vers "le jardin clos de Copilot ", affirme Butterick. Qualifiant Copilot de "parasite " qui exploite les contributeurs de logiciels libres, il accuse Microsoft de "trahir tout ce que GitHub représentait ".

Consentement non exigé

Il peut être tentant de rejeter toute la responsabilité de la controverse sur Copilot sur un seul mauvais acteur, Microsoft. Le géant de la technologie est étroitement lié à OpenAI, ayant investi un milliard de dollars dans la société et cherchant à investir davantage. On pourrait dire que les grandes entreprises technologiques dans leur ensemble ont l'habitude d'exploiter les données des utilisateurs à des fins lucratives (nous n'avons pas besoin d'aller plus loin que Meta et Google), mais le fait qu'il n'existe aucune règle ou norme concernant la formation des systèmes d'IA n'aide pas non plus.

Légalement, rien n'empêche des entreprises comme OpenAI et Stability AI (surtout connue pour son générateur de texte-image Stable Diffusion) d'entraîner leurs modèles d'IA sur des informations personnelles, des contenus protégés par le droit d'auteur, des images médicales... en fait, tout ce qui a été mis en ligne. Les ensembles de données sur lesquels ces modèles d'IA générative sont entraînés sont constitués de grandes quantités de données non filtrées provenant de tout l'internet. Il incombe à l'entreprise à l'origine d'un produit d'IA donné de l'affiner en éliminant les textes et images offensants ou sexuellement explicites. Cependant, les entreprises d'IA ne sont guère incitées à aller plus loin. Des outils tels que Have I Been Trained aident les utilisateurs à rechercher leurs données parmi les matériels de formation à l'IA accessibles au public afin qu'ils puissent demander leur suppression, mais c'est une goutte d'eau dans l'océan de la protection de la vie privée et des données. Tout d'abord, il n'est pas facile de les trouver là, et ensuite, personne ne garantit qu'elles seront supprimées. De plus, si vous avez trouvé vos données dans l'ensemble de données, cela signifie qu'elles ont probablement déjà été utilisées pour l'entraînement de l'IA et qu'elles peuvent déjà faire partie d'un produit alimenté par l'IA.

En d'autres termes, dans la pratique, vous ne pouvez refuser que vos données soient utilisées pour l'apprentissage de l'IA qu'une fois que le navire a déjà pris la mer. L'affaire Copilot semble avoir été la première fois que quelqu'un a contesté le mécanisme d'apprentissage de l'IA et ses résultats devant un tribunal, et constitue donc une étape importante, mais les critiques s'accumulent depuis un certain temps. Au début de l'année, un syndicat d'artistes basé au Royaume-Uni a lancé une campagne pour "empêcher l'IA de voler la vedette". L'une de ses principales demandes est que le gouvernement rende illégale la reproduction par l'IA des performances des artistes sans leur consentement.

Ainsi, l'absence de mécanisme d'exclusion et la question du consentement ont été mises au premier plan du débat sur l'IA.

Ce n'est pas ce que vous faites, c'est comment vous le faites

Comme l'écrit Butterick, la principale objection des "créateurs", qu'ils soient programmeurs (comme dans le cas de Copilot) ou artistes visuels, ne porte pas sur la technologie de l'IA en général, mais sur la manière dont les entreprises qui créent ces outils les conditionnent à agir.

*Nous pouvons facilement imaginer une version de Copilot plus favorable aux développeurs de logiciels libres - par exemple, lorsque la participation est volontaire, ou lorsque les codeurs sont payés pour contribuer au corpus d'entraînement", écrit-il.

Certaines plateformes, comme Getty Imagesinterdisent complètement l'art généré par l'IA, d'autres essaient d'aller dans la direction indiquée par Butterick. Par exemple, Shutterstock, qui a récemment commencé à vendre du contenu généré par l'IA dans le cadre de son partenariat avec OpenAI et LG, a annoncé qu'elle allait ajouter une fonction de retrait aux comptes des contributeurs. Cette fonction "permettra aux artistes d'exclure leur contenu de tout ensemble de données futur s'ils préfèrent que leur contenu ne soit pas utilisé pour l'entraînement de la technologie de vision par ordinateur". En outre, Shutterstock a créé un fonds pour les contributeurs, qui sera utilisé pour indemniser les artistes dont la propriété intellectuelle a été utilisée dans le développement des modèles générateurs d'IA. DeviantArt fait de même en offrant aux créateurs un moyen d'empêcher les systèmes d'IA de récupérer leur contenu. Une balise HTML spéciale s'appliquera aux pages des artistes de DevianArt qui ont demandé que leur travail soit exempté de l'apprentissage de l'IA. Les tiers devront filtrer le contenu comportant cette balise conformément aux conditions d'utilisation de la plateforme. Il convient de noter que, techniquement, les systèmes d'IA seront toujours en mesure d'aspirer ces données.

Toutefois, ces exemples de bonne volonté sont rares et il est peu probable qu'ils deviennent la norme sans une réglementation appropriée. L'action en justice de Copilot, outre le fait qu'elle jette davantage de lumière sur la question de la formation à l'IA, pourrait bien déclencher ce changement nécessaire. Et même si une seule plainte n'est pas susceptible de changer le système, elle peut provoquer un effet domino, ouvrant la voie à des contestations juridiques similaires et à une réglementation éventuelle.À l'heure où les nouveaux produits d'IA poussent comme des champignons, nous devons contrôler les entreprises qui en sont à l'origine avant qu'il ne soit trop tard et qu'elles aient déjà englouti toutes nos données.

Le problème est encore aggravé par le fait que les grandes entreprises technologiques, notoirement connues pour leur mépris de la vie privée et de la protection des données des utilisateurs, mènent la révolution de l'IA. Il a été rapporté que Google travaille sur plusieurs projets de code d'IA, dont un portant le nom de code Pitchfork. Cet outil secret, qui est toujours en cours de développement, permettrait à l'IA d'écrire et de corriger son propre code. L'idée derrière ce projet était de rationaliser les mises à jour de la base de code du langage de programmation Python de Google. À savoir : se débarrasser des ingénieurs logiciels, et laisser l'IA faire le travail. Selon Business Insider, qui s'est entretenu avec des sources chez Google, les objectifs du projet ont depuis changé pour faire de l'outil un "système polyvalent ".

Nouvelle technologie, ancien modèle d'utilisation abusive des données

Il reste à voir ce qui ressortira de la tentative des programmeurs de GitHub de défier Copilot et si cela aura un effet d'entraînement sur l'industrie dans son ensemble. D'une part, le problème de l'IA est apparu parce que la technologie qui alimente les systèmes d'IA générative est nouvelle et qu'elle s'aventure dans le territoire gris entre l'utilisation équitable et la violation du droit d'auteur.

D'autre part, le problème est aussi vieux que le monde. Au cœur du problème se trouve le mauvais traitement des données des utilisateurs par les entreprises technologiques qui les considèrent comme leur propriété. Nous pouvons essayer de résoudre la partie spécifique à l'IA de l'énigme en concevant certaines règles et réglementations, mais comme nous l'avons vu dans les tentatives de l'UE et des États-Unis de protéger nos données personnelles contre les Big Tech, même les lois les plus strictes ne sont pas une panacée. Les grandes entreprises chercheront toujours des échappatoires et des solutions de contournement pour contourner les règles de confidentialité et les lois sur la protection des données. Mais cela ne signifie pas que nous ne devons pas, en tant que communauté, faire pression sur les gouvernements pour qu'ils élaborent ces règles et sur les géants de la technologie pour qu'ils les respectent.